目次

はじめに

統計解析や機械学習で頻繁に使われる「重回帰分析」ですが、その精度と信頼性を脅かす要因の一つが「多重共線性(multicollinearity)」です。本記事では、多重共線性とは何か、なぜ問題になるのか、どのように検出し、どう対処すれば良いのかを、数式・図解・実例を交えて1万字のボリュームで解説します。

1. 多重共線性とは何か?

多重共線性とは、重回帰分析において説明変数(独立変数)同士に強い相関関係がある状態を指します。数学的には、ある変数が他の変数の線形結合により説明できるような関係性がある場合、多重共線性が存在すると言います。

たとえば、以下のような状況を考えてみましょう:

textコピーする編集するX1: 家の広さ(㎡)

X2: 部屋の数

X3: 家の値段(目的変数)

家の広さと部屋の数には当然ながら強い正の相関があります。このような説明変数間の相関が高い場合、モデルの推定値が不安定になり、信頼できないものとなるのです。

2. なぜ多重共線性が問題なのか?

多重共線性があると、以下のような問題が発生します。

- 回帰係数の推定値が不安定になる

小さなデータ変更で大きく値が変動する。 - p値が大きくなり、統計的有意性が見えなくなる

本来有意な変数が「有意ではない」と判断されてしまう。 - 解釈が難しくなる

各変数が個別に与える影響が不明確になる。

3. 多重共線性の原因

- サンプルサイズが小さいのに説明変数が多すぎる

- 同義語的な変数の使用(例:売上金額と利益額)

- データのスケーリングが不適切

- 意図せず作成されたダミー変数の冗長性

4. 多重共線性の検出方法

相関係数行列

説明変数間の相関係数を確認し、|r| > 0.8程度の相関があれば注意が必要。

VIF(分散拡大係数)

pythonコピーする編集するfrom statsmodels.stats.outliers_influence import variance_inflation_factor

VIF > 10 であれば強い共線性があると見なされます。

条件数(Condition Number)

固有値の比を取った条件数が30以上の場合、強い共線性の可能性があります。

5. 多重共線性による影響

(ここでは、Pythonのstatsmodelsを用いた具体的な分析例を交えて解説)

- 回帰係数が極端な値に

- p値が極端に高くなる

- R²は高いのに、モデルの意味がない

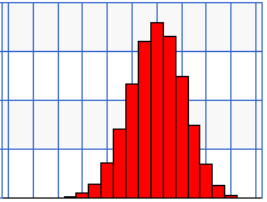

6. 多重共線性の具体例

実際のPythonコード(Pandas + statsmodels)を使って、

共線性あり/なしのケースを比較。

pythonコピーする編集するimport pandas as pd

import statsmodels.api as sm

# ダミーデータ作成と共線性の確認など

7. 多重共線性の対処法

多重共線性は、複数の説明変数(独立変数)が強く相関していることで、回帰分析の信頼性を損なう問題です。以下は、主な対処法です。

相関係数行列の確認と変数の除去

説明変数同士の相関係数を確認し、相関の強い変数を1つ削除する。

目安として、相関係数が±0.8以上の場合は要注意。

VIF(Variance Inflation Factor:分散拡大係数)の活用

VIFが10を超える場合、多重共線性が強いと判断されることが多い。

高VIFの変数を削除または変換する。

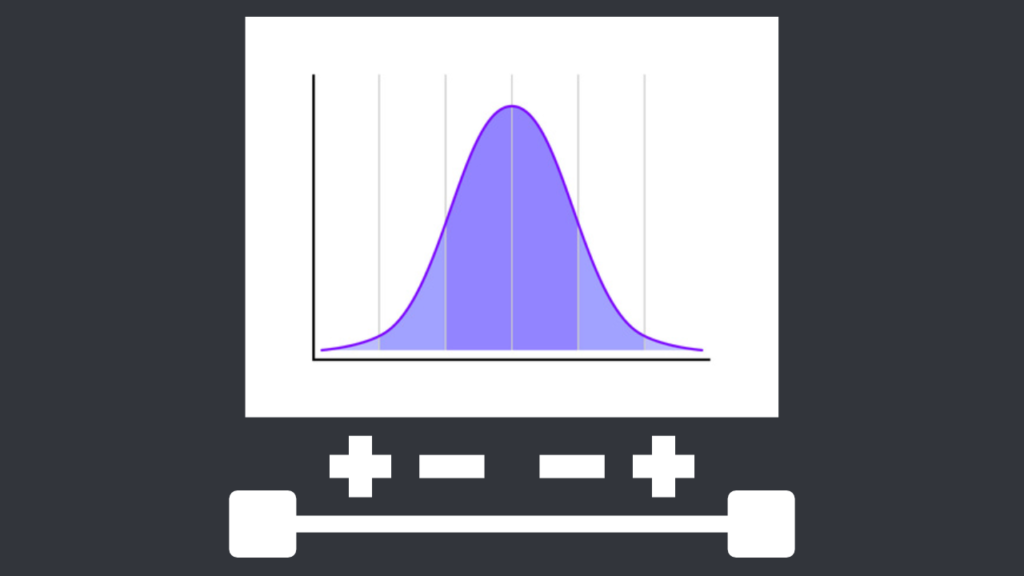

主成分分析(PCA)

高次元かつ相関の高いデータセットに対して、主成分を用いて次元を圧縮する。

回帰モデルの入力として主成分を使用することで、多重共線性の影響を抑える。

リッジ回帰やLASSO回帰の利用

リッジ回帰はL2正則化によって、係数を安定化させ多重共線性の影響を緩和する。

8. 実務での対応戦略と注意点

- 実際の業務では、「完全な解消」よりも「影響の最小化」が現実的です。以下のような実践的アプローチが有効です。

- ビジネスの意味合いを優先して変数を選ぶ

- 変数を単に統計的に除去するのではなく、業務上の重要度を考慮。

- たとえば「広告費」と「マーケティング予算」が高い相関を示していても、意思決定に必要であれば残す。

- 説明力よりも予測力を優先する場合はリッジ回帰などを使う

- 回帰係数の解釈よりも精度を重視する場合は、正則化モデルの方が有利。

- モデルの解釈性を保ちたい場合は、変数の合成や選択を行う

9. よくある誤解とFAQ

- R²が高いから共線性の心配は不要?

- 共線性があっても予測には問題ない?

10. まとめ

多重共線性はモデルの解釈性と安定性に深刻な影響を与えます。しかし、VIFのチェックや正則化手法を用いることで、実務レベルでは十分に対処可能です。回帰分析を実務で使う際には、必ず一度は多重共線性の有無をチェックしましょう。