勾配消失問題(Vanishing Gradient Problem)は、深層学習(ディープラーニング)のモデルを訓練する際にしばしば直面する重要な課題です。この問題が発生すると、モデルの学習が停滞し、パフォーマンスが向上しにくくなります。本記事では、勾配消失問題の基本原理、原因、そして対策について詳しく解説します。

勾配消失問題の仕組み

勾配消失問題は、ニューラルネットワークの**逆伝播法(Backpropagation)**による学習中に発生します。逆伝播法では、誤差(損失)を出力層から入力層に向けて伝搬させ、各層の重みを調整します。この過程で、次のような現象が起こります。

勾配が小さくなる仕組み

- ネットワークが多層構造の場合、各層で勾配(重みの更新量)を計算する。

- 勾配は各層を通過するたびに、活性化関数の微分値によって減少する。

- 出力層に近い層では大きな勾配が得られるが、入力層に近い層では勾配が極端に小さくなり、学習が停滞する。

勾配消失が起こる原因

1. 活性化関数の特性

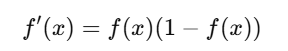

勾配消失問題は主にシグモイド関数や双曲線正接(tanh)関数を活性化関数として使用した場合に発生しやすいです。

- シグモイド関数: 出力が0または1に近づくと勾配が非常に小さくなります。

この式から、入力値が極端に大きい(または小さい)場合、勾配がゼロに近づくことがわかります。

2. 深層化による累積的な勾配の減少

ネットワークが深くなるほど、多くの層を経由することで勾配が指数関数的に小さくなります。このため、入力層や中間層の重みが適切に更新されません。

勾配消失問題の影響

- 学習速度の低下: 重みの更新が極めて遅くなるため、学習が進まない。

- モデル性能の劣化: ネットワークの深い層が学習されないため、表現力が制限される。

- 過学習のリスク: 出力層や浅い層のみが学習され、過学習が発生しやすくなる。

勾配消失問題への対策

1. 活性化関数の変更

勾配消失問題を軽減するために、以下のような活性化関数を採用します。

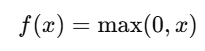

- ReLU(Rectified Linear Unit)関数:

- ReLUは、勾配がゼロになる領域(負の入力)を持ちますが、正の入力領域では勾配が一定のため、勾配消失が起きにくいです。

- Leaky ReLU: ReLUの改良版で、負の領域でも微小な勾配を持つ。

- Swish関数:

Googleが提案した新しい活性化関数で、勾配消失をさらに抑える効果があります。

2. パラメータ初期化の工夫

適切な重みの初期化は勾配消失問題を軽減します。以下の手法がよく使われます。

- Xavier初期化: シグモイドやtanhを使う場合に有効。

- He初期化: ReLUを使う場合に有効。

3. Batch Normalization(バッチ正規化)

バッチ正規化は、各層の入力を標準化することで、勾配の安定化を図る手法です。これにより、学習がスムーズに進みます。

4. 残差ネットワーク(Residual Network, ResNet)

ResNetは、スキップ接続を導入して、勾配が層を飛び越えて伝播する仕組みを提供します。これにより、勾配消失の影響を大幅に軽減します。

Pythonでの勾配消失問題のデモ

以下のコードは、シグモイド関数とReLUを使った場合の勾配消失問題の比較を示します。

import numpy as np

import matplotlib.pyplot as plt

# シグモイド関数とReLUの定義

def sigmoid(x):

return 1 / (1 + np.exp(-x))

def relu(x):

return np.maximum(0, x)

# 入力データと勾配計算

x = np.linspace(-10, 10, 100)

sigmoid_grad = sigmoid(x) * (1 - sigmoid(x))

relu_grad = np.where(x > 0, 1, 0)

# プロット

plt.figure(figsize=(10, 5))

plt.plot(x, sigmoid_grad, label='Sigmoid Gradient')

plt.plot(x, relu_grad, label='ReLU Gradient')

plt.title('勾配消失問題の比較')

plt.xlabel('入力')

plt.ylabel('勾配')

plt.legend()

plt.show()

勾配消失問題の重要性

勾配消失問題は、特にディープラーニングが普及し始めた初期において大きな課題でした。しかし、現在ではReLUやBatch Normalization、ResNetなどの技術により、ほとんどの状況で解決可能になっています。それでも、非常に深いネットワークを構築する際には、問題を意識し続けることが重要です。

まとめ

勾配消失問題は、ニューラルネットワークを深層化する際に避けられない課題でしたが、近年のアルゴリズムや手法の発展により、克服可能になっています。この記事で紹介した対策を活用し、安定したモデル学習を実現してください。

データ分析のキャリアを目指すあなたへ!

統計学や機械学習は、データサイエンスやAIエンジニアリングの基盤となる分野です。

こうした知識を深め、実践的なスキルを身につければ、需要の高いAI関連職種でのキャリア形成も目指せます。

未経験からでも安心して学べるおすすめのキャリア支援サービスについて、こちらの記事で詳しく解説していますので、ぜひチェックしてみてください。